ふえたんだが、epub自動生成があまりにも小気味よく動くので、タイトルをちらっと見て放り込むというムーブをやってしまう。

読んでみるとそんなでもないやつもたくさんあって、さすがに1ページ目くらいは読んでからやったほうがいいなと反省している。句読点を知らん人が書いたやつとかマジで地獄。

青空文庫は未着手だが、あそこの難点の一つに「おもろいのかどうかがガチでわからない」というものがある。

読んでみると何かのあとがき的な文章だったりすることもあって、有志がテキスト化しているサイトのカオスがそこにある。

カクヨムとかは読者の評価が数値化されているので、少なくとも「みんなが面白いと言ってる話」を濾し取ることが容易だ。

わたしが探しているのは掘り出し物じゃなくて「ぽかんと読めるテキスト」だから、一定の評価がついた作品を集めるほうがいい。

フォルダがクソ散らかる

全300話の小説をrpubにしました、みたいな場合。

あちらのサイトを何度も殴らなくていいように、一回読んだページはローカルにhtmlを保存して、キャッシュしている。

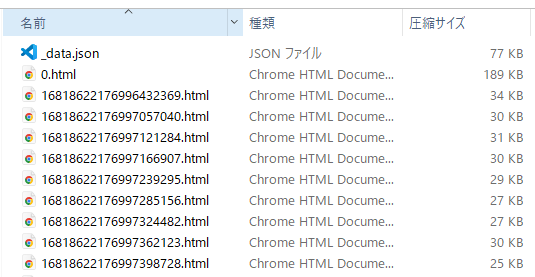

そうなるとローカルに300枚のhtmlが保存される。

で、安直に記事や小説をepub変換しまくると、これが冊数ぶん保存される。

ファイル数が多いのはものすごくPCによくない。

圧縮するか。

落っことしてきたhtmlファイルは、自分にとっては不要なタグを削除する的な前処理をやったあとで、zipに放り込むようにした。

当然だけど、素のファイルがフォルダにある状態より、zipからいちいち取り出すほうがコストは掛かる。

けど、キャッシュの目的が「いらん負荷をDLもとのサイトにかけない」ことにあるので、ローカルのパフォーマンスには目をつぶって構わない。そもそも数百程度のファイルの読み書きだったら違いは体感できないから、なおさら問題がなかった。

Calibreはコマンドラインも使えるっぽい

勘違いしてたんだが、Kindle事態のデータ形式はAZWというものらしい。中身は事実上epubだかmobiだかなんだけど、DRM用のあれこれが追加されているとか。

で、AZWの作り方は公開されておらず、パンピーが触る道具でいうとCalibreがそれを可能にしていると。

epubから変換するスクリプトも見つけたんだけど、中でCalibreをコマンドラインで呼び出してるんのよね。

で、自分とこにこの手のやつをどかどかいれるのは避けたいので、Calibre入りのDockerコンテナを作る必要が出てくる。

うええ、めんどくさい。

epubこさえてamazonのページにドラッグするので困ってないし、いまはいいか。